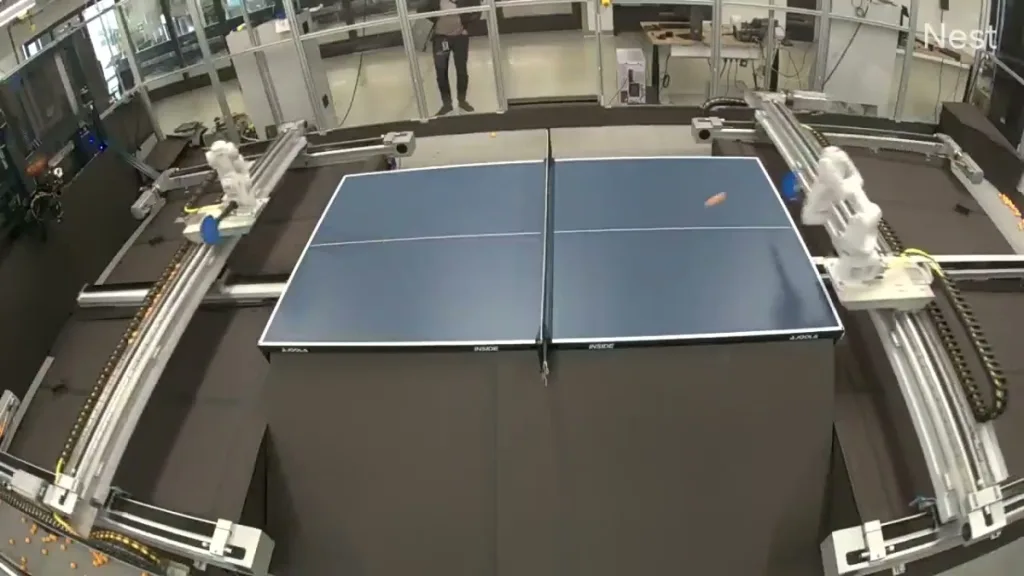

Google coloca dois robôs para disputar partida infinita de tênis de mesa

Experimento da DeepMind usa o tênis de mesa para testar aprendizado autônomo em robôs e avançar no desenvolvimento de IA aplicada ao mundo real

Dois braços robóticos jogando tênis de mesa sem parar são a nova aposta da DeepMind, do Google, para desenvolver sistemas de inteligência artificial capazes de aprender sozinhos, sem supervisão constante.

O esporte foi escolhido por exigir habilidades complexas, como reação rápida, precisão motora e adaptação a situações imprevisíveis, desafios parecidos com os que robôs enfrentam em ambientes reais, como casas ou hospitais.

A tecnologia se baseia em aprendizado por reforço, no qual os robôs recebem “recompensas” por acertos e ajustam suas estratégias ao longo do tempo.

Eles começaram em partidas cooperativas e, depois, passaram a competir entre si e contra humanos. Jogando com pessoas, os sistemas melhoraram o desempenho e chegaram a vencer 55% dos adversários intermediários.

Além do treino físico, os robôs também contam com uma espécie de técnico virtual: o modelo Gemini, da própria DeepMind.

Ele analisa as jogadas em tempo real e dá instruções em linguagem natural, como “tente bater mais perto da lateral”. O projeto busca soluções mais eficientes e escaláveis para o futuro da robótica.

Deixe um comentário